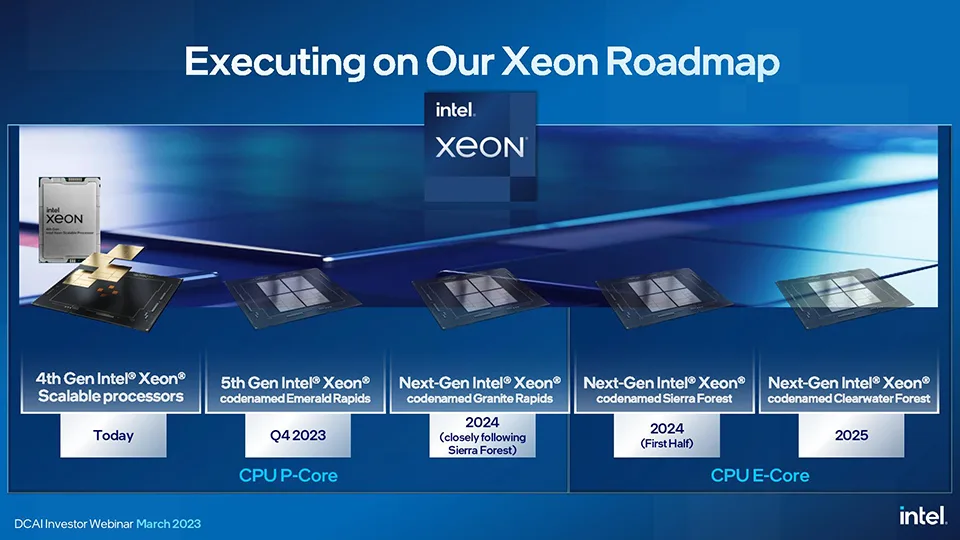

Intel ha celebrado hoy una presentación online centrada en su negocio sobre centros de datos e inteligencia artificial en la que ha dado a conocer la gama de procesadores Xeon para servidores que tiene previsto lanzar hasta 2025.

Durante la emisión, Intel ha indicado que está diseñando dos familias de chips Xeon diferentes: los P-Core (Performance Core), que únicamente incluyen núcleos que ofrecen el mayor rendimiento posible, y los E-Core (Efficiency Core), que cuentan con núcleos más eficientes energéticamente y con una mayor densidad.

En el grupo de los P-Core se incluyen el Xeon Emerald Rapids que se lanzará en el último trimestre de este año y el Xeon Granite Rapids que llegará en 2024. Los E-Core están representados por el Xeon Sierra Forest, que está previsto que se comercialice durante la primera mitad de 2024, y el Xeon Clearwater Forest que se estrenará en 2025.

Intel explica que Emerald Rapids ofrecerá un mejor rendimiento, más eficiencia y núcleos que Sapphire Rapids, el modelo que se lanzó hace sólo unos meses. Granite Rapids, por su parte, se fabricará con el nodo Intel 3 de 3 nanómetros y contará con un número superior de núcleos respecto a Emerald Rapids y un mayor ancho de banda de memoria.

Sierra Forest, el primer modelo de la familia E-Core que verá la luz, integrará una CPU de 144 núcleos y superará de esta manera a la del Epyc Bergamo desarrollado por AMD, que tiene 128 núcleos. En cambio, no será un procesador multihilo como el de AMD, que sí podrá ejecutar múltiples hilos en paralelo.

Los detalles que se han facilitado acerca de Clearwater Forest son escasos, más allá de que se fabricará con el nodo 18A de Intel, que será equivalente a un proceso de 1,8 nanómetros de la competencia, y ofrecerá una mejora en el rendimiento por vatio del 10% respecto a 20A. Intel tiene grandes esperanzas en este nodo y confía que le permitirá, por primera vez en muchos años, superar la tecnología de TSMC, algo que de ser cierto supondría todo un golpe de efecto.

Finalmente, y por lo que hace referencia a la inteligencia artificial, Intel ha subrayado que el 60% de los modelos de lenguaje se seguirán ejecutando en CPUs, especialmente los pequeños y medianos, mientras que en los modelos de lenguaje de gran tamaño como el GPT-4 que impulsa a ChatGPT o Bing Chat se utilizarán tarjetas gráficas específicas como la Nvidia A100.

La galaxia espiral NGC 4845

La galaxia espiral NGC 4845 Alien: Rogue Incursion, anunciado para el PS VR2, SteamVR y Meta Quest 3

Alien: Rogue Incursion, anunciado para el PS VR2, SteamVR y Meta Quest 3 Shadow of the Ninja Reborn se lanzará el 29 de agosto

Shadow of the Ninja Reborn se lanzará el 29 de agosto El RPG de acción That Time I Got Reincarnated as a Slime ISEKAI Chronicles llega el 8 de agosto

El RPG de acción That Time I Got Reincarnated as a Slime ISEKAI Chronicles llega el 8 de agosto